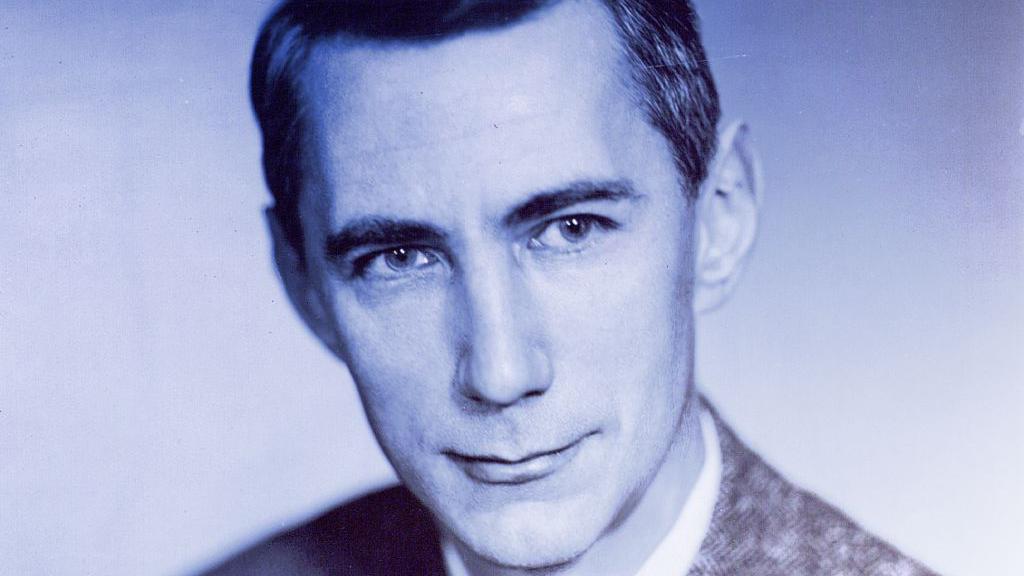

Claude Shannon, el genial matemático que inventó la era digital (y luego se retiró a su "cuarto de juguetes")

BBC News Mundo - Redacción | Sábado 08 febrero, 2025

Hay muchas cosas memorables sobre Claude Shannon.

Quienes trabajaron con él en los Laboratorios Bell en Nueva York, Estados Unidos, lo recordaban recorriendo los pasillos en un monociclo mientras hacía malabarismos con cuatro pelotas.

Sus colegas en Instituto Tecnológico de Massachusetts (MIT) contaban que tenía sobre su escritorio un artilugio de su propia creación llamado la "Máquina Definitiva", una caja con un botón que, al prenderla, salía una mano mecánica y la apagaba.

Sin olvidar, por supuesto, que a los 21 años escribió "la tesis de maestría más importante de todos los tiempos", sentando las bases para todas las futuras computadoras digitales.

Ni tampoco que a los 32 años publicó lo que Scientific American llamó "la Carta Magna de la era de la información", pues inventó el bit, y explicó cómo comprimir y enviar cualquier mensaje con perfecta precisión.

Es por eso que muchos, al referirse a él, declaran que Shannon se inventó el futuro.

O, más bien, el presente en el que vivimos.

Y no exageran: su contribución dio la arquitectura intelectual de internet y la era digital.

"En los Laboratorios Bell y en MIT hubo muchos que compararon la intuición de Shannon con la de Einstein. Otros consideraron que esa comparación era injusta... injusta con Shannon", según el autor de "La fórmula de la fortuna", William Poundstone.

No obstante, su nombre no trascendió tanto como el de otros célebres científicos de su época.

¿La razón?

"Porque así fue como él lo quiso", señaló Rob Goodman, coautor de la biografía de Shannon "Una mente en juego".

"Se alejó conscientemente de la fama", agregó en una sesión con Quora.

Pero, además, porque su legado es relativamente intangible.

"Es fácil imaginar una computadora, pero más difícil imaginar el salto creativo que demostró que los interruptores o circuitos podían evaluar enunciados lógicos", indicó Goodman.

"Es fácil imaginar un teléfono inteligente, pero más difícil imaginar las ideas sobre la naturaleza de la información y la comunicación que hicieron posible ese teléfono inteligente.

"Shannon trabajó en ese nivel fundamental e intangible, razón por la cual es venerado entre los expertos, pero un tanto invisible para el público en general".

Esa tesis

Tras graduarse en la Universidad de Michigan en 1936, Shannon trabajó como asistente de laboratorio para el pionero de la informática Vannevar Bush, vicepresidente y decano de ingeniería de MIT.

Solía ayudar a científicos visitantes a usar el "analizador diferencial", la computadora más poderosa del mundo en ese entonces, creada por Bush.

La enorme máquina análoga usaba un sistema preciso de ejes, engranajes, ruedas y discos para resolver ecuaciones de cálculo.

Para solucionar cada problema había que reorganizar todo el mecanismo de manera que sus movimientos correspondieran a la ecuación adecuada.

¿Pesadilla?

No para Shannon.

Desde niño, además de deleitarse resolviendo problemas matemáticos que su hermana le pasaba, se divertía reparando radios, construyendo juguetes y hasta convirtió una cerca de alambre de púas en una línea telegráfica para comunicarse con un amigo.

Así que pasarse horas manipulando ese complejo mecanismo era un placer.

Y, al hacerlo, el engranaje de su mente trabajaba mucho más rápido que el de la máquina, como evidencia su tesis de máster, "Un análisis simbólico de los circuitos de relés y de conmutación".

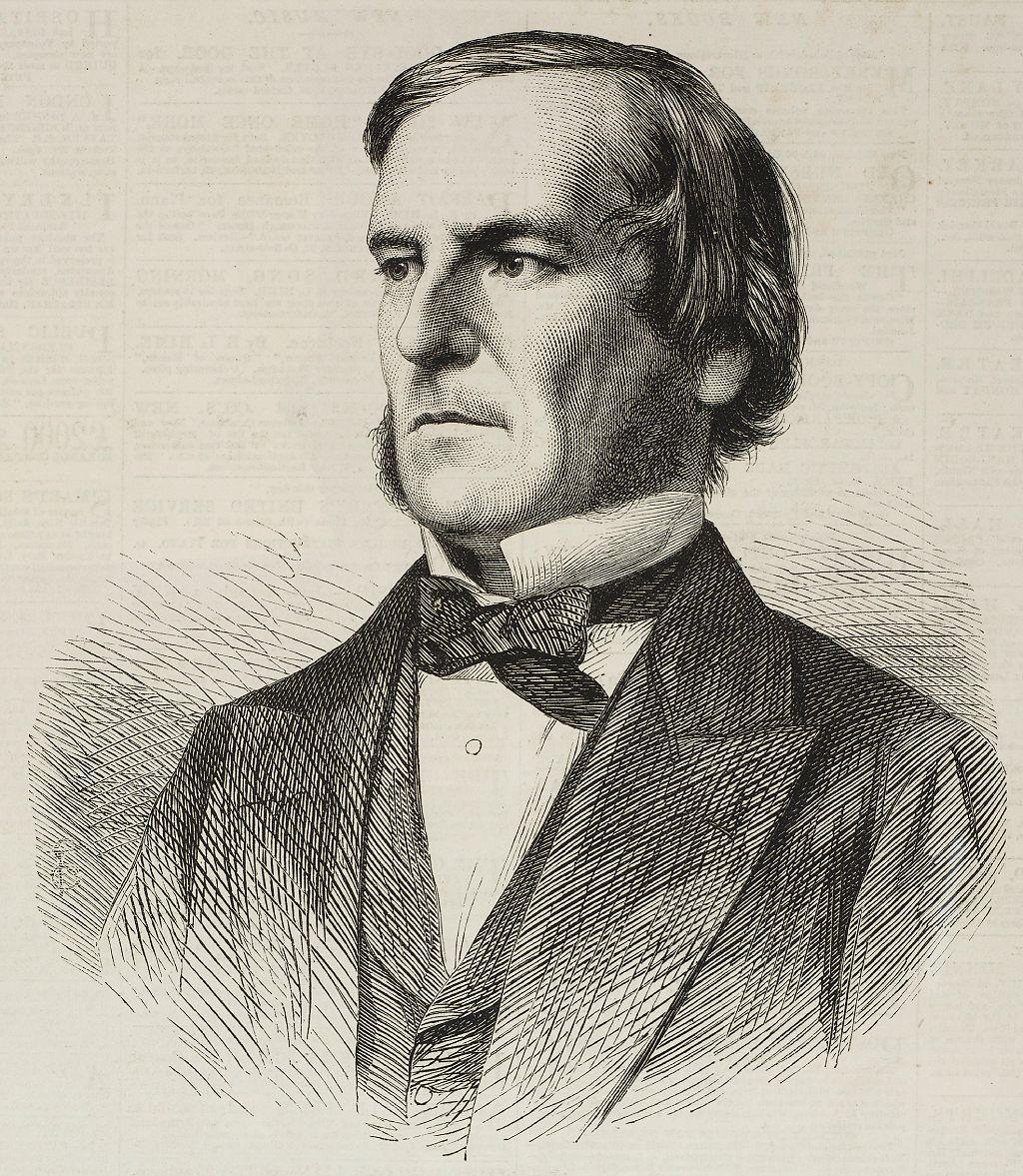

En Michigan se había graduado como ingeniero eléctrico y matemático, y había tomado un curso de filosofía en el que conoció la obra del filósofo del siglo XIX George Boole.

Todo eso se conjugó cuando observó que la relación entre los interruptores eléctricos y la corriente podía imitar el proceso intelectual de la lógica simbólica y las matemáticas.

Los interruptores del circuito de control, que podían abrirse y cerrarse automáticamente, correspondían a la elección binaria de la lógica, en la que una afirmación es verdadera o falsa.

En el álgebra de Boole a las afirmaciones se les asignan valores: 1 a las verdaderas, y 0 a las falsas.

Basándose en esa teoría, Shannon aplicó el valor "1" a los circuitos abiertos y el valor "0" a los cerrados.

Además, en el álgebra booleana, las afirmaciones se pueden considerar junto con conjunciones como "y", "no", y "o".

Entonces, por ejemplo, algo como "si suena la alarma por la mañana y no es fin de semana, entonces tienes que ir a trabajar" sería el equivalente lingüistico de "si el número X no es igual al número Y, entonces realiza la operación Z" en el circuito de interruptores.

Una muestra de cuán fundamental fue su tesis es que hoy podemos fácilmente reconocer que eso es programar una computadora.

Pero entonces era una noción nueva que, cuando más tarde se puso en práctica, despertó asombro: implicaba que las máquinas tenían la capacidad de decidir qué hacer por sí solas... como los humanos.

Así, escribió Shannon, "es posible realizar operaciones matemáticas complejas por medio de circuitos de interruptores", pues podían adoptar cursos de acción alternativos según las circunstancias.

Con ese método simple y brillante emitió "el certificado de nacimiento de la revolución digital", declaró Alain Vignes en su libro "El silicio, de la arena a los chips".

Una esposa computadora

Shannon había tenido la idea crucial para organizar las operaciones internas de un computador moderno casi una década antes de que existieran.

Pero cuando habló con el ex editor de la revista Spectrum John Horgan en 1982, le restó importancia.

"Simplemente sucedió que nadie más estaba familiarizado con esos dos campos al mismo tiempo", dijo, y agregó: "Siempre me ha gustado esa palabra, 'booleano'".

"Me divertí más haciendo eso que cualquier otra cosa en mi vida", le dijo a otro periodista.

Bajo el ala de Vannevar Bush, Shannon decidió complementar su maestría con un doctorado.

Bush pensaba que especializarse en un solo tema sofocaba una mente brillante, así que le aconsejó hacer su tesis doctoral sobre genética, cuenta la revista MIT Technology Review.

¿Brillaría incluso sin tener conocimientos previos en un campo?

Cuando la completó, Henry Phillips, el director del Departamento de Matemáticas del MIT, escribió que Shannon podía "hacer una investigación de primera clase en cualquier campo en el que se interese".

Poco después de obtener su doctorado, Shannon se fue a trabajar a AT&T Bell Laboratories.

Era 1940 y Europa estaba bajo la sombra de la Segunda Guerra Mundial, un conflicto en el que EE.UU. no se había querido involucrar directamente pero que quizás, como ocurrió, no iba a poder evitar.

Así que Shannon se puso inmediatamente a trabajar en proyectos militares como el control del fuego antiaéreo y la creación y descifrado de códigos, incluido uno que Churchill y Roosevelt utilizaron para conferencias transoceánicas.

Y conoció a quien sería su segunda esposa, Mary Elizabeth "Betty" Moore, una de las "computadoras" de Bell Labs.

Así se les llamaba a las personas, a menudo mujeres, que usaban y operaban las máquinas de la unidad de informática para encontrar soluciones matemáticas a través de lo que hoy llamamos programación.

Betty era analista numérica y se convirtió en asesora de Shannon en cuestiones matemáticas.

La Carta Magna

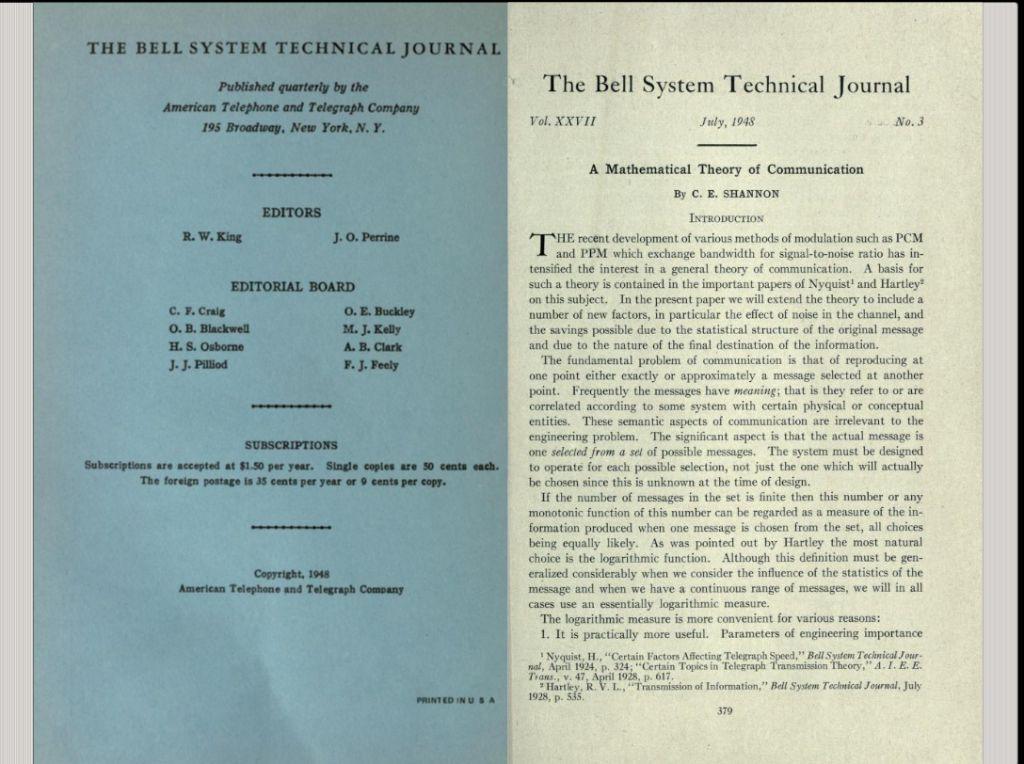

Mientras trabajaba en lo urgente para la guerra, Shannon escribió "Una teoría matemática de la criptografía", finalizada en 1945 pero clasificada y, por lo tanto, no publicada hasta 1949.

Los entendidos consideran que con ella transformó la criptografía de un arte a una ciencia.

En ella exploró, entre otras cosas, la naturaleza y redundancia del lenguaje, temas que revisitaría en su obra maestra "Una teoría matemática de la comunicación".

La había estado formulando simultáneamente, en sus ratos libres.

Shannon había notado que, así como los códigos podían proteger la información de miradas indiscretas, también podían protegerla del ruido o la distorsion que sufría al ser transmitida, ya fuera por la estática u otras formas de interferencia.

Además, esos códigos podían usarse para empaquetar información más eficientemente, para poder transmitir una mayor cantidad de ella por telégrafo, radio, televisión o teléfono.

Comprendió que el significado semántico de un mensaje era irrelevante para su transmisión: no importaba qué decía, la cuestión era cómo cuantificar la información.

Para ello, definió las unidades de información, los fragmentos más pequeños posibles, y los llamó "bits" (o "bytes"), término que fue sugerido por su colega John Tukey como abreviatura de 'dígito binario'.

Para expresar información en un bit, se usaría un 1 o un 0.

Cadenas de esos bits se podían utilizar para codificar cualquier mensaje pues describían todo, desde palabras hasta imágenes, canciones, videos y el software de juegos más sofisticado.

Aunque esas ráfagas de bits sufrían los mismos problemas que una señal analógica, es decir, debilitamiento y ruido, la digital tenía una ventaja: los 0 y los 1 eran estados tan claramente diferentes que, incluso después del deterioro, su estado original podían reconstruirse mucho más adelante.

Estas ideas y otras más contenidas en su Teoría matemática de la comunicación, como lo que llamó el "teorema fundamental" de la teoría de la información, eran proféticas.

Un concepto radical que altería para siempre la comunicación electrónica.

Como un rayo

Shannon, sin embargo, no tenía prisa por publicar.

"Estaba más motivado por la curiosidad", explicó en una entrevista con la revista Omni, en 1987, añadiendo que el proceso de escribir para su publicación era "doloroso".

Finalmente superó su reticencia y su pionero artículo apareció en el Bell System Technical Journal en 1948.

El efecto fue inmediato y electrizante.

"Fue como un rayo caído del cielo", recuerda John Pierce, uno de los mejores amigos de Shannon en Bell Labs.

La revista Fortune, por ejemplo, la calificó como "una gran teoría científica que podría alterar profunda y rápidamente la visión del mundo del hombre".

Para Warren Weaver, director de la División de Ciencias Naturales de la Fundación Rockefeller, la teoría abarcaba "todos los procedimientos mediante los cuales una mente puede afectar a otra", incluyendo "no sólo el lenguaje escrito y oral, sino también la música, las artes pictóricas, el teatro, el ballet y, de hecho, todo el comportamiento humano".

Efectivamente, la teoría de Shannon cautivó a un público mucho más amplio que aquel al que estaba destinada.

Lingüistas, psicólogos, economistas, biólogos y artistas intentaron fusionarla con sus disciplinas.

A medida que la popularidad crecía, Shannon comenzó a preocuparse de que sus ideas se estuvieran usando indiscriminadamente y, por lo tanto, perdiendo su enfoque y significado.

En retrospectiva, no había razón para temer: la mayoría de las aplicaciones de su teoría a otras disciplinas, como la biología, la neurociencia o el análisis de redes sociales, han sido sólidas y muy valiosas.

Su obra era tan revolucionaria y general que sería empleada en una plétora de campos, desde internet hasta la información genética en el ADN, a pesar de que la formuló décadas antes de que existiera la web o se descubriera la doble hélice.

En cualquier caso, la preocupación no le duró mucho.

Mientras la comunidad académica seguía digiriendo el impacto de la teoría de la información, los intereses de Shannon cambiaron.

La suya no era sólo una mente teórica brillante, sino también una mente extraordinariamente divertida, práctica e inventiva, apunta Jimmy Soni, coautor de "Una mente en juego".

Así que se dedicó más de lleno a algo que siempre le había fascinado.

Durante gran parte de la década de 1950, Shannon pasó sus días en el laboratorio soñando y luego construyendo ingeniosos dispositivos.

Algunos resultaron ser prototipos de lo que hoy se denomina inteligencia artificial.

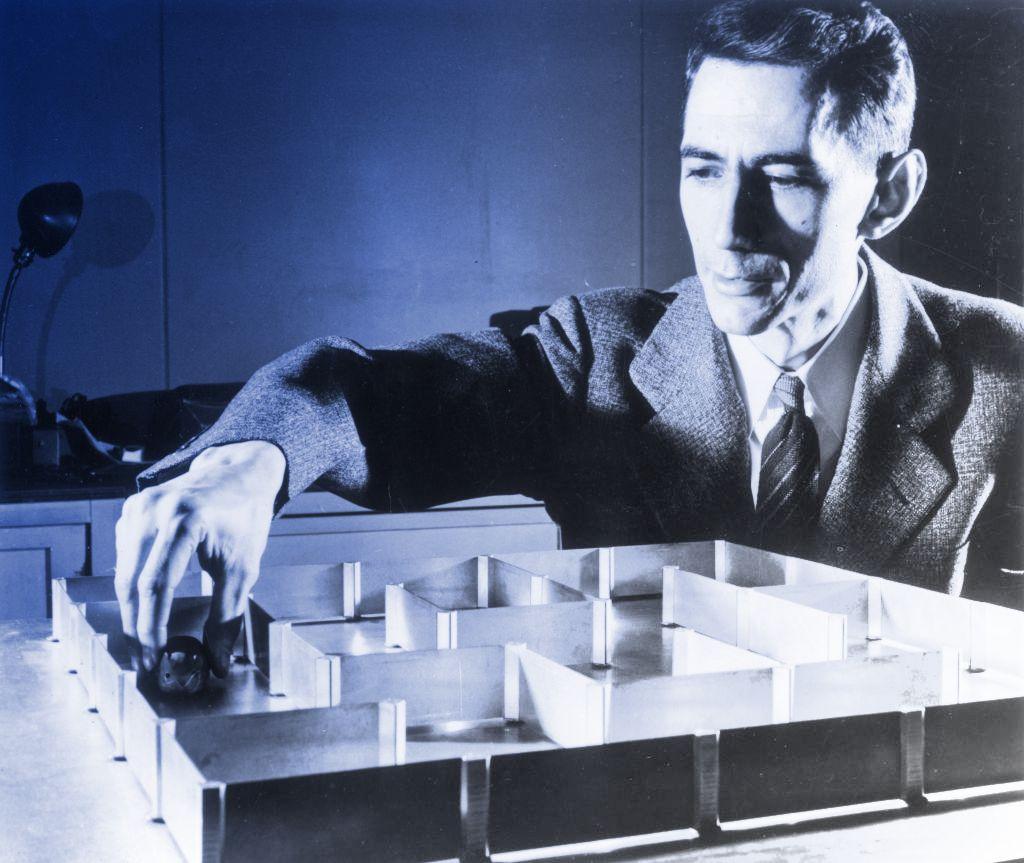

Entre ellos, el famoso Teseo, un ratón que podía resolver un laberinto mediante ensayo y error. Además, podía recordar la solución y también olvidarla en caso de que la situación cambiara y la solución ya no fuera aplicable.

O la máquina que "leía la mente". Tenía dos luces y un botón. El jugador adivinaba en voz alta si el artilugio encendería la luz izquierda o derecha, apretaba el botón, y una de las dos luces se encendía.

El éxito de la máquina dependía del registro de patrones.

Pero su motivación no era práctica.

"Hago lo que me sale naturalmente y la utilidad no es mi objetivo principal. Me gusta resolver problemas nuevos todo el tiempo", explicó en una ocasión.

"Me sigo preguntando: ¿Es posible crear una máquina para hacer eso? ¿Puedes demostrar este teorema? Estos son los tipos de problemas que abordo. No porque vaya a hacer algo útil".

Y eso estaba bien para su jefe, Henry Pollak, director de la división de matemáticas de Bell Labs, pues Shannon "se había ganado el derecho a ser improductivo".

Cosas inútiles

Ya desde poco después de publicar su teoría, Shannon había rechazado casi todas las numerosas invitaciones para dar conferencias o entrevistas.

No quería ser una celebridad.

Más tarde, comenzó a retirarse no sólo de la vista del público sino también de la comunidad de investigación, preocupando a sus colegas de MIT, que lo había contratado en en 1958.

"Escribía artículos hermosos, cuando escribía, y daba charlas hermosas, cuando daba una charla. Pero odiaba hacerlo", recordó el destacado teórico de la información Robert Fano en conversación con MIT Technology Review.

Seguía, sin embargo, inventando artilugios, como su THROBAC, una calculadora que utilizaba números romanos para todos los cálculos, y una computadora portátil para ganarle a la ruleta en los casinos.

E incursionó en la poesía con un homenaje al cubo de Rubik, titulado "Una rúbrica sobre las cúbicas de Rubik".

"Paso mucho tiempo en cosas totalmente inútiles", le dijo a Horgan.

Y otras más útiles: desarrolló varios modelos matemáticos para predecir el rendimiento de las acciones y los ha probó con éxito en la bolsa de valores.

No obstante, aunque cuando colegas o estudiantes lo consultaban les daba todo de sí, solía pasársela encerrado en su oficina y, a mediados de la década de 1960, dejó de enseñar.

Su retiro oficial fue en 1978, y Shannon se fue feliz a su Casa de la Entropía, como llamaba a su hogar en las afueras de Boston, donde tenía su cuarto de juguetes.

Su ingenio no había disminuido: "¡Todavía construía cosas!", recordó su esposa Betty al hablar con MIT Technology Review.

"Una era una figura de WC Fields que rebotaba tres pelotas en un tambor. ¡Hacía un ruido tremendo!".

La lista de sus creaciones es extensa.

Además de una variedad de máquinas diseñadas para jugar juegos abstractos, como el hexadecimal y un robot que resuelve el cubo de Rubik, hizo una trompeta que lanzaba llamas, un frisbee propulsado por cohetes, unos zapatos gigantes de poliestireno para poder caminar sobre el agua en un lago cercano...

... y muchos monociclos, en todas sus variantes: uno sin asiento; otro sin pedales; uno construido para dos; otro con una rueda cuadrada.

Muy rara vez se le veía en público, para el pesar de sus admiradores.

Pero en 1985, alentado por Betty, hizo una aparición inesperada en el Simposio Internacional de Teoría de la Información en Brighton, Inglaterra.

"Fue como si Newton hubiera aparecido en una conferencia de física", dijo el presidente del simposio, Robert J. McEliece.

Ese mismo año, tristemente, él y Betty comenzaron a notar ciertos lapsus de memoria, y en 1993 se confirmó que sufría de la enfermedad de Alzheimer.

La familia lo internó en un asilo de ancianos donde falleció en 2001.

"Claude hizo tanto por hacer posible la tecnología moderna que es difícil saber dónde empezar y dónde terminar", comentó el eminente ingeniero Robert G. Gallager, quien trabajó con Shannon en los años 60.

"Tenía una claridad de visión asombrosa. Einstein también la tenía: esa capacidad de abordar un problema complicado y encontrar la forma correcta de analizarlo, de modo que las cosas se vuelvan muy simples".

Haz clic aquí para leer más historias de BBC News Mundo.

Suscríbete aquí a nuestro nuevo newsletter para recibir cada viernes una selección de nuestro mejor contenido de la semana.

También puedes seguirnos en YouTube, Instagram, TikTok, X, Facebook y en nuestro nuevo canal de WhatsApp, donde encontrarás noticias de última hora y nuestro mejor contenido.

Y recuerda que puedes recibir notificaciones en nuestra app. Descarga la última versión y actívalas.

- La zairja, el Ars Magna y otros artilugios ideados a lo largo de la historia para eliminar las incertidumbres de la vida

- Origen de internet: la primera palabra con la que comenzó la fascinante historia de la red que cambió el mundo

- La desconocida historia de las 6 matemáticas que programaron la primera supercomputadora moderna

- El matemático que inventó hace más de 150 años cómo buscar en Google